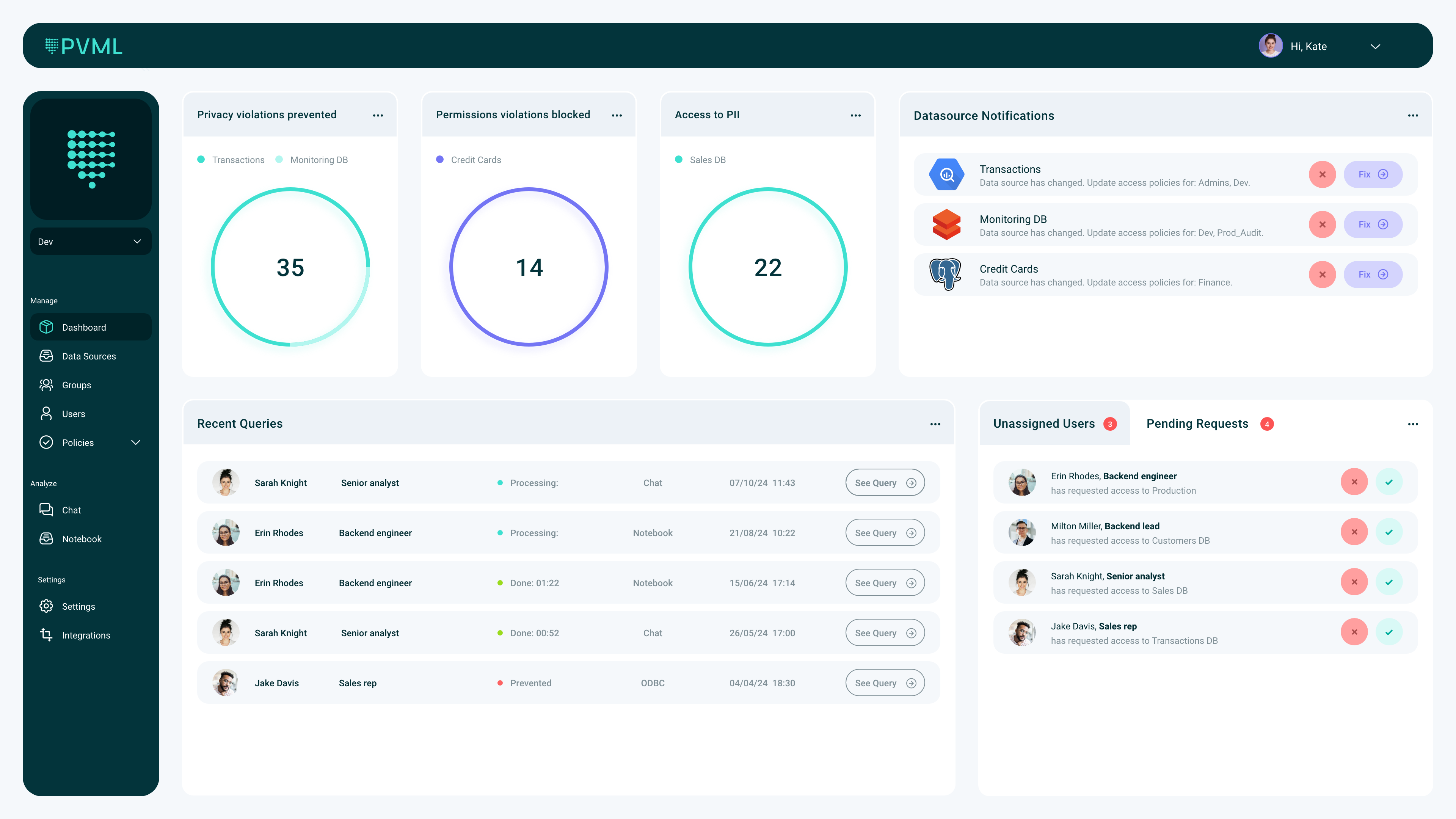

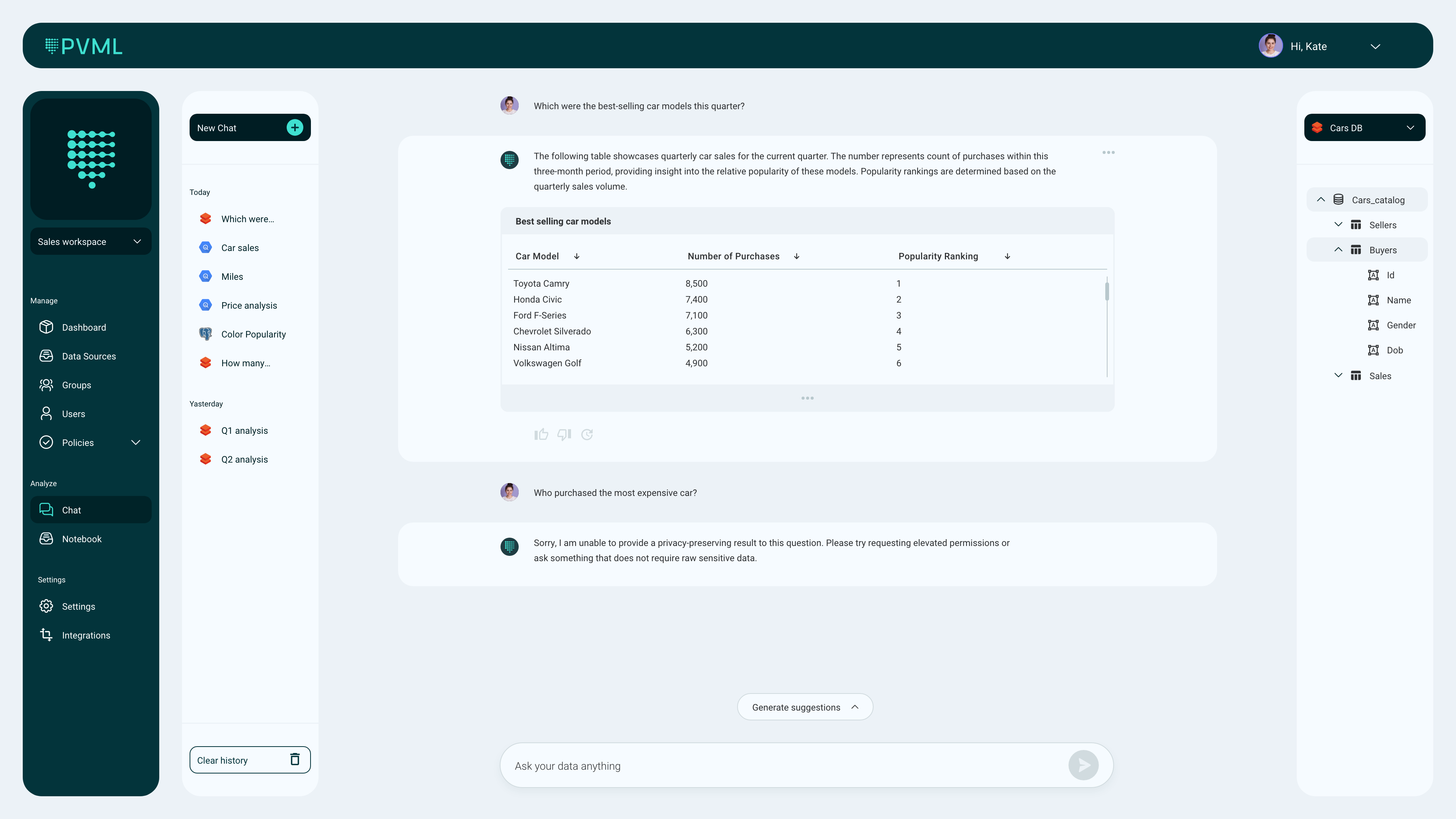

Les entreprises accumulent plus de données que jamais pour alimenter leurs ambitions en matière d'IA, mais en même temps, elles se soucient également de qui peut accéder à ces données, qui sont souvent de nature très privée. PVML offre une solution intéressante en combinant un outil similaire à ChatGPT pour analyser les données avec les garanties de sécurité de la confidentialité différentielle. En utilisant la génération augmentée par récupération (RAG), PVML peut accéder aux données d'une entreprise sans les déplacer, éliminant ainsi une autre considération en matière de sécurité.

La société basée à Tel Aviv a récemment annoncé avoir levé 8 millions de dollars lors d'un tour de table de financement de démarrage, mené par NFX, avec la participation de FJ Labs et Gefen Capital.

La société a été fondée par le couple Shachar Schnapp (PDG) et Rina Galperin (CTO). Schnapp a obtenu son doctorat en informatique, se spécialisant dans la confidentialité différentielle, et a ensuite travaillé sur la vision par ordinateur chez General Motors, tandis que Galperin a obtenu son master en informatique avec un focus sur l'IA et le traitement du langage naturel et a travaillé sur des projets d'apprentissage automatique chez Microsoft.

"Une grande partie de notre expérience dans ce domaine provient de notre travail dans de grandes entreprises et de grandes sociétés où nous avons constaté que les choses ne sont pas aussi efficaces que ce que nous espérions en tant qu'étudiants naïfs, peut-être", a déclaré Galperin. "La principale valeur que nous voulons apporter aux organisations en tant que PVML est de démocratiser les données. Cela ne peut se produire que si vous protégez, d'une part, ces données très sensibles, mais, d'autre part, permettez un accès facile, ce qui aujourd'hui est synonyme d'IA. Tout le monde veut analyser les données en utilisant un texte libre. C'est beaucoup plus facile, plus rapide et plus efficace - et notre ingrédient secret, la confidentialité différentielle, permet cette intégration très facilement."

La confidentialité différentielle n'est pas un concept nouveau. L'idée principale est de garantir la vie privée des utilisateurs individuels dans de grands ensembles de données et de fournir des garanties mathématiques à cet égard. L'une des façons les plus courantes d'y parvenir est d'introduire un degré de randomisation dans l'ensemble de données, mais de manière à ne pas modifier l'analyse des données.

L'équipe fait valoir que les solutions actuelles d'accès aux données sont inefficaces et créent beaucoup de surcharge. Souvent, par exemple, une grande quantité de données doit être supprimée dans le processus permettant aux employés d'accéder de manière sécurisée aux données - mais cela peut être contre-productif car vous ne pourrez peut-être pas utiliser efficacement les données expurgées pour certaines tâches (en plus du délai supplémentaire pour accéder aux données signifie que les cas d'utilisation en temps réel sont souvent impossibles).

La promesse d'utiliser la confidentialité différentielle signifie que les utilisateurs de PVML n'ont pas à apporter de modifications aux données originales. Cela évite presque toute la surcharge et débloque ces informations en toute sécurité pour les cas d'utilisation de l'IA.

Pratiquement toutes les grandes entreprises technologiques utilisent désormais la confidentialité différentielle d'une manière ou d'une autre, et mettent à disposition leurs outils et bibliothèques aux développeurs. L'équipe de PVML fait valoir qu'elle n'a pas vraiment encore été mise en pratique par la plupart de la communauté des données.

"Les connaissances actuelles sur la confidentialité différentielle sont plus théoriques que pratiques", a déclaré Schnapp. "Nous avons décidé de passer de la théorie à la pratique. Et c'est exactement ce que nous avons fait : nous développons des algorithmes pratiques qui fonctionnent le mieux sur des données dans des scénarios de la vie réelle."

Aucun des travaux sur la confidentialité différentielle n'aurait d'importance si les outils d'analyse de données et la plateforme réelle de PVML n'étaient pas utiles. Le cas d'utilisation le plus évident ici est la possibilité de discuter avec vos données, avec la garantie qu'aucune donnée sensible ne peut fuiter dans la discussion. En utilisant RAG, PVML peut réduire les hallucinations à presque zéro et la surcharge est minimale car les données restent en place.

Mais il y a aussi d'autres cas d'utilisation. Schnapp et Galperin ont noté comment la confidentialité différentielle permet également aux entreprises de partager désormais des données entre les unités commerciales. De plus, elle peut également permettre à certaines entreprises de monétiser l'accès à leurs données auprès de tiers, par exemple.

"Sur le marché boursier aujourd'hui, 70% des transactions sont effectuées par l'IA", a déclaré Gigi Levy-Weiss, associé général de NFX et co-fondateur. "C'est un avant-goût de ce qui nous attend, et les organisations qui adoptent l'IA aujourd'hui seront en avance demain. Mais les entreprises ont peur de connecter leurs données à l'IA, car elles craignent l'exposition - et pour de bonnes raisons. La technologie unique de PVML crée une couche de protection invisible et démocratise l'accès aux données, permettant des cas d'utilisation de monétisation aujourd'hui et ouvrant la voie pour demain."